卷积神经网络概述

CNN的核心作用在于借助特定方法从对象中抽取出有效细节,再利用这些细节完成对象的归类、辨认、预估或决断等任务。其中最关键的环节是细节抽取,重点在于如何获得最能区分不同对象的细节。倘若抽取的细节无法有效区分彼此,那么这一细节抽取环节就失去了实际价值。而实现这个伟大的模型的,是对CNN进行迭代训练。

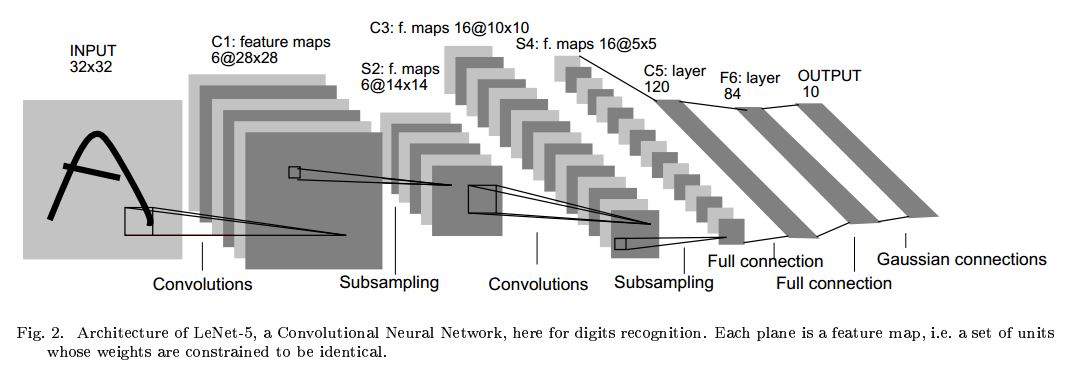

卷积神经网络的构造方式多种多样,不过其核心组成大体相同,以LeNet-5为例加以说明,具体展示于下图,该网络主要由三类基本单元构成,分别是卷积单元、汇聚单元以及全连接单元。这部分包含卷积层,其作用是提取输入数据的特征信息。该层由大量卷积核构成,每个卷积核负责生成特定的特征图。

非线性由激活函数赋予卷积神经网络,典型代表包括sigmoid函数,tanh函数,以及ReLU函数,这些是常用选择。

池化环节削减卷积环节得出的特征矩阵,并且有助于提升效果(让构造不轻易产生过拟合现象),常见的有均值池化和最大池化这两种方式

全连接层通过叠加卷积层和Pooling层,可以构成一个或多个全连接层,从而具备进行复杂推理的能力。

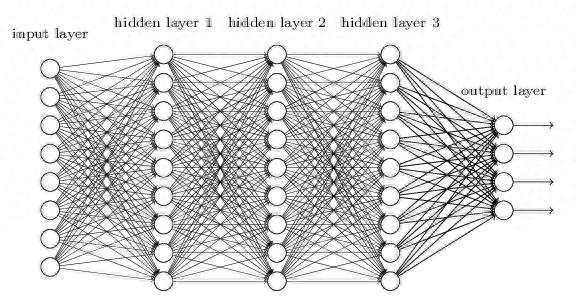

全连接神经网络

举个小例子:

卷积神经网络各层关系图

该图所示卷积网络运作方式如下,其输入层包含三十二行三十二列的感知单元,用于接收原始图像,随后计算过程会在卷积运算与子采样步骤之间循环执行,具体操作如下所述:

第一隐藏层执行卷积操作,该层包含六个特征图,每张特征图由28×28个处理单元构成,每个处理单元对应一个5×5的区域作为其感知窗口

第二隐藏层负责子采样工作,同时执行局部平均操作kaiyun全站登录网页入口,该层包含六个特征映射,每个特征映射由 14×14 个神经元构成。每个神经元配备一个 2×2 的感受野,一个可训练参数,一个可训练偏置kaiyun官方网站登录入口,以及一个 sigmoid 激活机制。可训练参数和偏置共同决定神经元的运作状态。

第三层再次执行卷积运算,这一层包含十六组特征映射,每组特征映射由一百个神经元构成。该层中的每个神经元可能与下一层中的多个特征映射建立突触联系,其运作方式与初始卷积层类似。

第四个隐层执行二次子采样及局部均值运算。该层包含十六个特征映射,每个映射构成五乘五的神经元矩阵,运作模式与初次采样时类似。

第五个隐藏层负责完成卷积的最后步骤,这个层包含 120 个神经元单元,每个神经元对应一个 5×5 的感受区域。

最后是个全连接层,得到输出向量。

连续不断地在卷积运算和下采样步骤之间切换,形成了类似“双峰塔”的结构,具体表现为,每当经过一个卷积或下采样环节,图像的空间清晰度就会降低,而特征图的数量则相对于前一层有所增长。采用卷积处理之后再实施子采样这种设计思路,其灵感来源于生物视觉系统中“初级”神经元紧随“高级”神经元排列的现象。

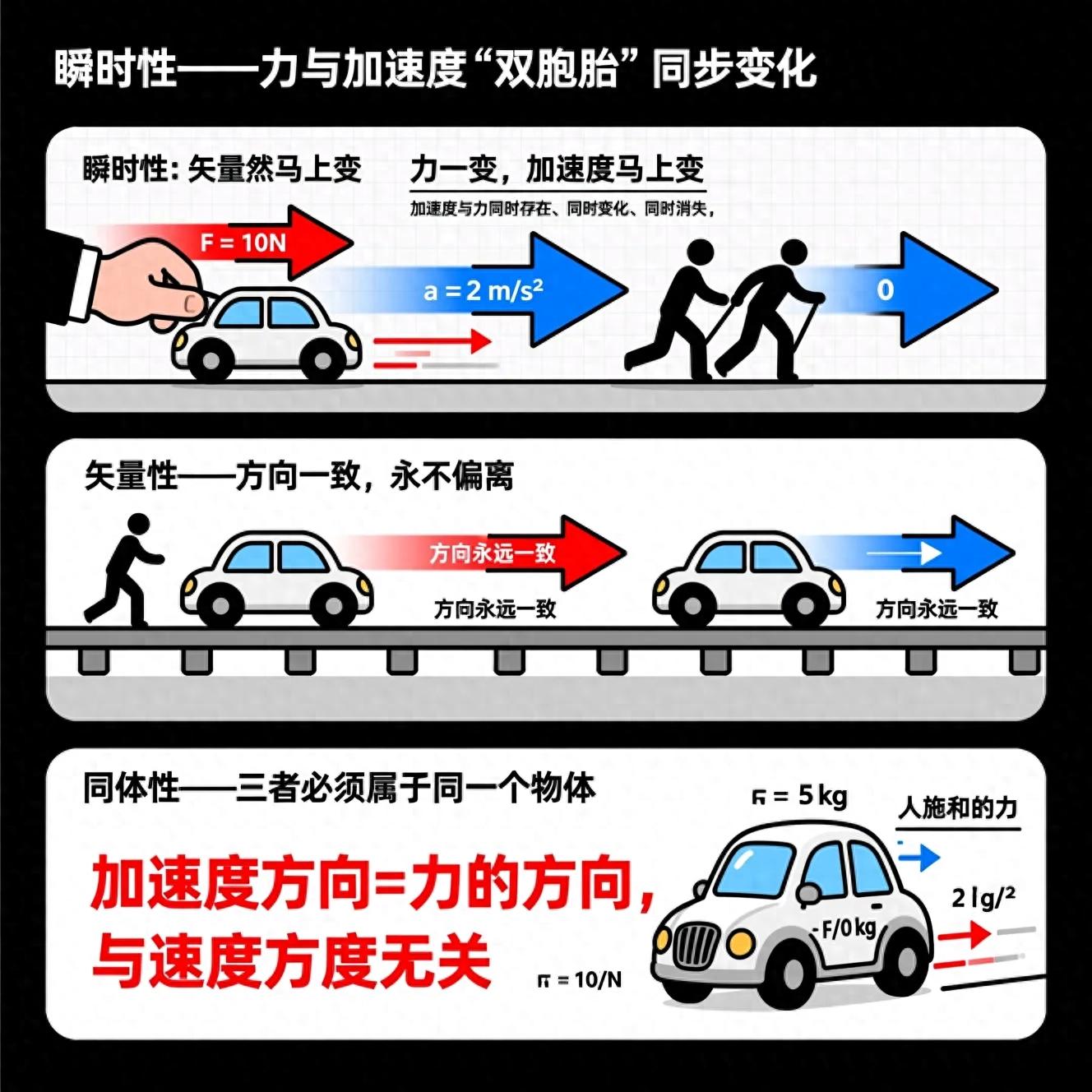

卷积的特点

局部感知

卷积核的尺寸通常小于输入图像的尺寸,假如两者相等,就属于全连接模式,因此卷积操作提取的特征更侧重于局部区域——这种做法与日常图像处理的需求高度契合。单个神经元无需感知整个图像,仅需要处理局部区域的信息,随后在更高级别的层次上整合局部信息,从而形成对全局的把握。

参数共享

参数共享最大的作用莫过于很大限度地减少运算量了。

多核

通常情况下,都不会仅用一个卷积核来对输入图像实施处理,因为单个核的参数是固定的,其提取的特征也会趋于单调。这有点类似于我们平时如何公正地审视事物,必须从多个视角进行分析,这样才能尽可能防止对该事物形成片面认知。我们也需要借助多个卷积核来对输入图像执行卷积操作。

Down-Pooling

卷积过程完成之后,紧接着使用池化层,这种组合方式非常理想,它能够有效地集中特征信息kaiyun全站网页版登录,同时降低数据的维度,以此减轻计算负担。

多层卷积

层数越高,提取到的特征就越全局化。