看华为卷积运算芯片如何提高AI资源利用率?

当前,深度神经网络技术已成为人工智能领域的核心算法之一。依托这一技术,字符识别、图像分类以及语音识别等关键功能已得到广泛应用,并融入了搜索引擎、智能手机等众多产品之中。

目前,最有效且应用最广的神经网络算法是卷积神经网络算法,通常简称为“卷积运算”。在现有技术体系里,CNN算法的核心计算单元依赖于乘加运算,其中,乘法累加器阵列在矩阵乘法运算中经常被使用。实际上,卷积运算可以被转化为矩阵乘法运算的形式。

业界普遍选用MAC(乘累加器)阵列作为计算核心的专用加速设备,诸如现场可编程门阵列(FPGA)、专用集成电路(ASIC)等,旨在提升卷积运算的执行效率。

然而,当前卷积计算面临若干挑战,首先,在多个卷积窗口并行执行卷积操作时,它们散布在MAC阵列的不同区域,导致MAC阵列的效能显著降低;其次,有大量冗余数据从RAM传输至MAC阵列,这无疑增加了RAM的访问频率。

为了应对这一问题,华为创造性地研发了一种AI芯片,该芯片将CPU、RAM以及卷积运算芯片整合至一个统一的数据总线之中。在2016年12月29日,华为成功申请了一项名为“卷积运算芯片与通信设备”的专利技术(申请编号:201611243272.X),申请主体为华为机器有限公司。

依据该专利目前已公开的详细信息,让我们共同探究华为所推出的新型人工智能芯片架构吧。

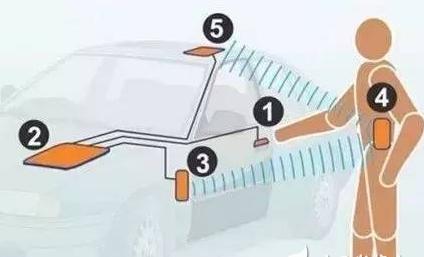

该图展示了该专利所涉及硬件设备的结构示意图,图中包含中央处理器100、双倍速率同步动态随机存储器200以及卷积运算芯片300。CPU负责指挥卷积运算芯片启动卷积计算过程,DDR SDRAM则向卷积运算芯片的数据缓存模块输送大量卷积数据以及多个卷积参数,随后,卷积运算芯片依据这些输入数据进行卷积运算。

运算结果一旦获取,便会被存入DDR SDRAM中预定的存储位置,同时向CPU发出信号kaiyun官方网站登录入口,告知其运算已完成,以便CPU能够从相应地址提取所需数据。

图示展示了该框架中卷积运算芯片的结构,该芯片主要由数据缓存模块310、M*N乘法累加器阵列320、输出控制模块330以及阵列控制模块340构成。

数据缓存模块主要负责向乘法累加器的首个乘法累加窗口输送多个用于卷积计算的卷积数据以及相应的卷积参数。这些卷积参数是由数据缓存模块依据第一卷积参数矩阵来确定的。此外,该控制器通过在运算器内部集成此类数据缓存器,有效降低了对RAM的访问频率,从而减轻了RAM的访问压力。

M*N乘法累加器构成了该运算芯片的核心部分,该结构设计旨在实现卷积运算kaiyun全站网页版登录,具体构造可参考下方的图示。

这种乘法累加器内含M与N的乘积个处理单元开yun体育app官网网页登录入口,且每两行单元间设有斜向的数据传输路径,相较于传统矩阵式传输通道,其数据传输方式更为灵活,更适宜AI芯片执行各类运算。

该乘法累加窗口对数据进行乘法处理,随后执行加法操作以得出卷积结果,最终,输出控制模块将卷积神经网络的运算成果输出,从而实现AI芯片内的任务执行。

在所述专利中,为了最大限度地提升MAC阵列的使用率和卷积计算的效率,阵列控制模块会依据第一卷积参数矩阵的行数与第一卷积数据阵列的行数,进而确定第一乘法累加窗口的列数。

华为研发的卷积运算芯片,该芯片在提升阵列资源使用效率的同时,有效减少了RAM的访问频率,从而减轻了RAM的访问负担。以华为的昇腾AI芯片为例,它正是依托这项技术,才得以达到极高的计算能力,无论是多么复杂的模型都能轻松完成训练,并且实现了极低的能耗。